Discusión de resultados

A continuación, se discuten los resultados más relevantes de las respuestas a los formularios.

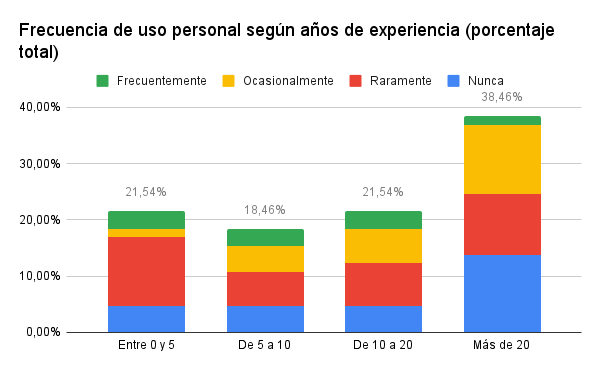

Figura 1

Gráfica de uso de los docentes de IA en su vida privada en función de sus años de experiencia

En esta gráfica de barras se ve representada la relación existente entre el uso de la inteligencia artificial y los años de experiencia docente. En ella, podemos constatar que la herramienta es utilizada con más frecuencia entre aquellos profesores que tienen más de 20 años de experiencia docente.

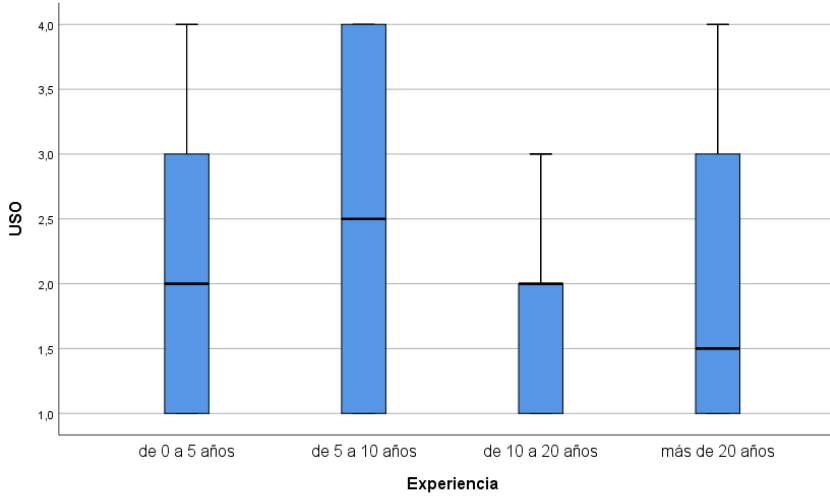

Figura 2

Representación gráfica de la relación existente entre el uso de la Inteligencia artificial y los años de experiencia docente

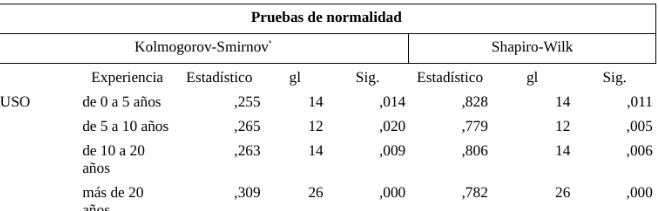

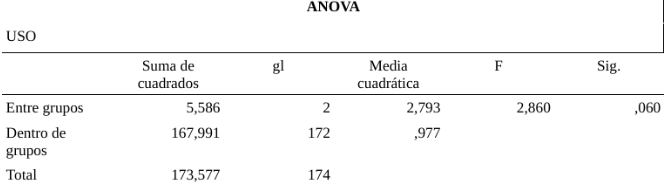

Tabla 1

Pruebas de normalidad de la variable uso de la IA en relación con la experiencia docente.

Corrección de significación de Lilliefors

La prueba de normalidad se lleva a cabo con el programa de cálculo estadístico spss, para cada una de las distribuciones. Si se cumplen con normalidad,esto es si la significancia asintótica bilateral obtenida en las pruebas de Shapiro-Wilk (para más de 50 sujetos de muestra) es <0.05 se considerará «no normal» y si el valor es >0.05 se considerará «normal». De esta manera podemos comparar con un test ANOVA ambas variables y así comprobar o refutar la hipótesis 2.

En la tabla se puede observar como la significancia entre grupos es mayor de 0,05 lo que quiere decir que las diferencias entre el uso de Chat GPT en contexto educativo según los años de experiencia no son significativas para un intervalo de confianza del 95%. Lo cual refuta nuestra segunda hipótesis.

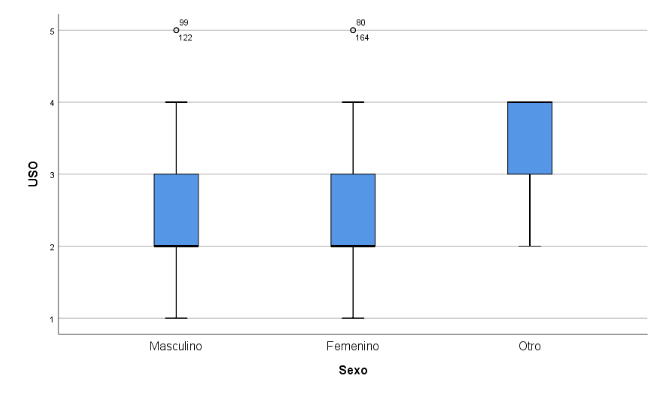

Figura 3

Representación gráfica de la relación entre el uso de la IA y el sexo

Figura 4

Relación entre el uso de la IA y los diversos grupos encuestados

Al ser una significancia entre grupos mayor al 0,05 no existen diferencias significativas, (si se toma el género como una variable dicotómica) lo que cumpliría nuestra tercera hipótesis (1.3). Sin embargo tal como se observa en el gráfico de cajas y bigotes, aquellas personas que se identifican con un género no binario presentan diferencias estadísticamente significativas con un mayor uso de la IA en el contexto educativo.

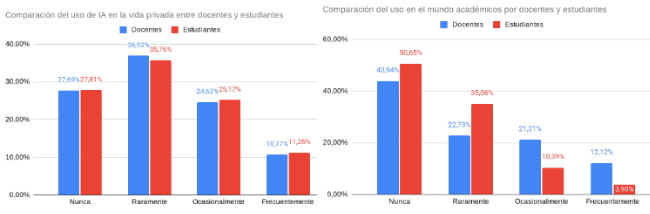

Figura 5

Gráficas comparativas entre la frecuencia de uso de profesores y estudiantes en el ámbito personal y académico

En esta figura (1= nunca, 5= a diario) se observa que el alumnado usa significativamente más la IA en el contexto educativo que el profesorado. No se cumple nuestra primera hipótesis (1.1)

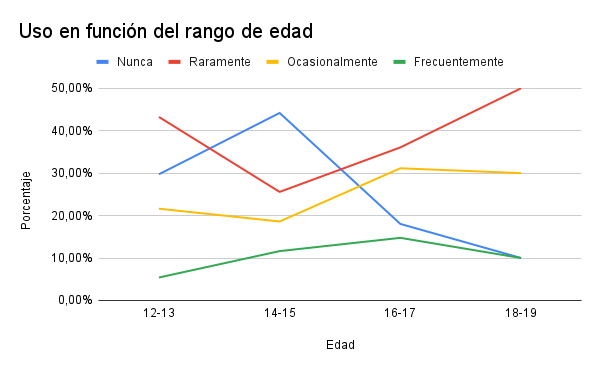

Figura 6

Gráfica de uso de los estudiantes de IA en su vida privada en función de su edad

En función a la variable edad, el uso «frecuentemente» es más común en el grupo de 16 a 17 años de edad con un reporte del 14,75%, tal y como se observa en la figura. La tendencia más común es usarla raramente, con el mayor número de reportes en cada grupo (un 43,24% frente al 29,73% de nunca, el 21,62% de ocasionalmente y el 5,41% de frecuentemente en el grupo de 12-13 años por ejemplo), excepto en el de 14 a 15 años, que es el grupo que menos reporta usarlo con la variable «nunca» en un 44,19%. Se observa como la variable nunca toma los menores valores en los dos grupos de mayor edad.

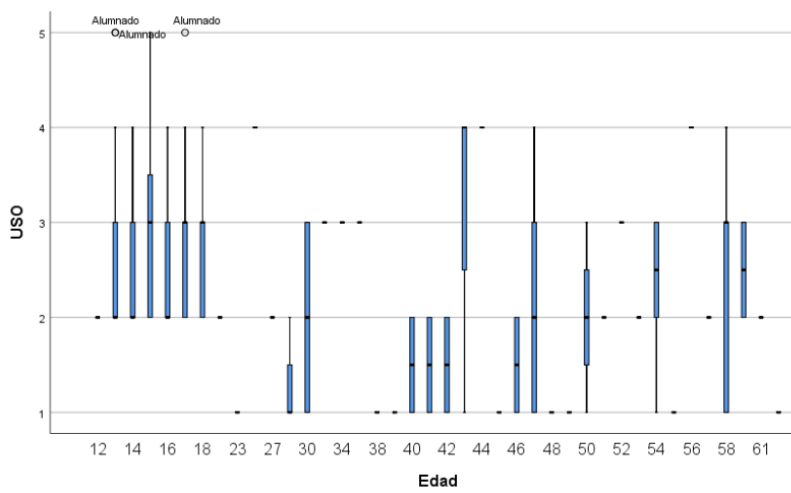

Figura 7

Análisis de barras y bigotes del uso de ChatGPT según la edad de los encuestados.

Aunque en general el alumnado hace mayor uso de la IA que el profesorado no se cumple la hipótesis cuatro de que el uso de la IA covaría positivamente con la edad entre el alumnado y negativamente entre el profesorado.

Figura 8

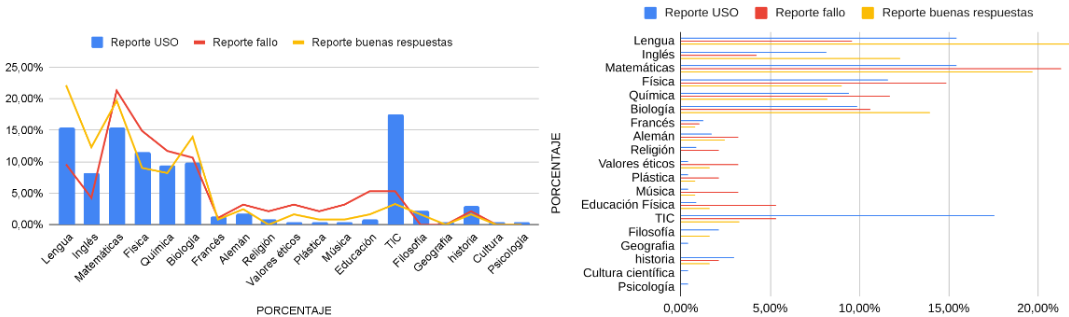

Gráficas comparativas entre el uso y el reporte de fallos o buenas respuestas

La asignatura en la que más uso se reporta es TIC, seguida de lengua y matemáticas. La asignatura en la que más fallos se reporta es matemáticas, seguida de física y biología. La asignatura en la que mejores respuestas se reporta es lengua, seguida de matemáticas e inglés. Por lo general el valor del uso de una asignatura es cercano al de su reporte de fallo y mejores respuestas. Aunque en casos como el de TIC se reportan mucho uso y poco fallo o mejores respuestas, siendo el primer caso algo más común. Esto corrobora nuestra hipótesis 5.

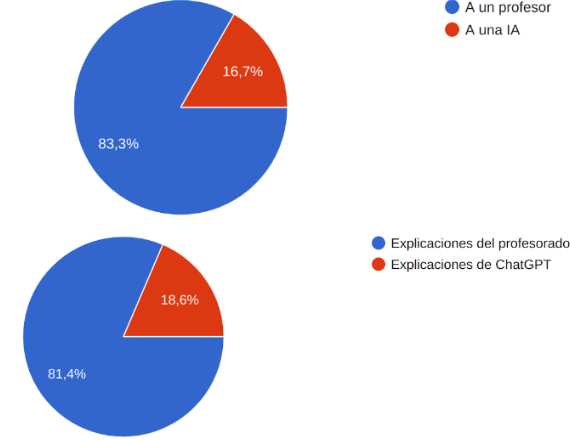

Figura 9

Gráficas sobre la preferencia a preguntar a un profesor o a una IA y la explicación de un profesor o de ChatGPT.

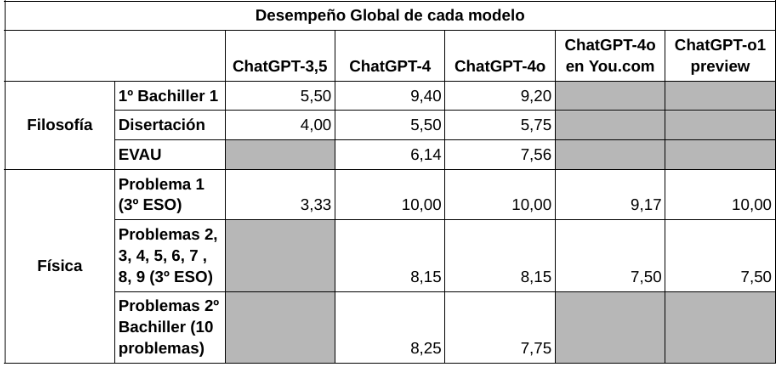

Tabla 2

Nota media de cada modelo en cada una de las pruebas.

En filosofía:

Los tres modelos muestran una alta capacidad a la hora de extraer, sintetizar o explicar un texto. Es decir, poseen una gran comprensión del lenguaje.

El modelo más reciente, ChatGPT-4o, es el que obtiene mejores resultados en casi todas las pruebas. Su desempeño global es el mejor exceptuando el primer examen de primero de Bachiller.

En la disertación se observa cómo los tres modelos tienen un rendimiento negativo. Se puede ver que el desempeño es malo en los tres modelos porque tienden a limitarse a copiar o parafrasear ideas del texto base proporcionado como apoyo en lugar de desarrollar argumentos originales. Esto muestra una falta de argumentación propia y reflexión crítica. Además, a diferencia de ChatGPT-4, los dos primeros modelos analizados no dan un contraargumento. En síntesis, el tratamiento que los tres modelos dan a la disertación se asemeja más al de un comentario de texto, pues se centran en analizar el contenido del texto base en lugar de generar una argumentación estructurada y fundamentada.

En los exámenes de EVAU solo se analiza a ChatGPT-4 y ChatGPT-4o. Sus medias son de 6,14 y 7,56 respectivamente. La diferencia de un punto se debe principalmente a que el segundo modelo explica con mayor claridad los conceptos y, en ocasiones, también profundiza mejor. Es destacable que, a veces, el modelo obtiene mejor calificación que el primero al captar más ideas fundamentales sin utilizar necesariamente una extensión más larga, lo cual demuestra que tiene una capacidad para explicar de forma precisa y concisa los conceptos.

En física:

Las conclusiones extraídas de los resultados de física utilizando ChatGPT-3.5 no han sido muy satisfactorias.

A diferencia del modelo anterior, las respuestas obtenidas por las distintas versiones de ChatGPT-4 (ChatGPT-4.o, ChatGPT o1-preview) en cuanto a los exámenes de cinemática de 3ºESO son mucho más satisfactorias. En la mayoría de los ejercicios llega a las respuestas correctas sin necesidad de introducir más prompts para aclarar confusiones y sin fallos. El modelo de pago da mejores resultados que la versión anterior en cuanto a la resolución de los ejercicios.

En cuanto a las respuestas de ChatGPT-4o ante los enunciados según el idioma en el que se introducen los prompts (inglés y español), destaca una discrepancia de respuestas en el quinto ejercicio realizado por you.com, sin embargo, el resto de ejercicios proporcionan los mismos resultados tanto en inglés como español, por lo que esta alternancia de resultados podría deberse a un saturación de la herramienta o simplemente a un fallo puntual por la IA.

Con respecto a los problemas extraídos de la unidad de interacción gravitatoria incluida en el temario de física en la selectividad, se observa que tanto ChatGPT-4 como ChatGPT-4o, solucionan los ejercicios de manera parecida, siendo el ChatGPT-4 un poco más eficaz. No obstante, al aumentar el nivel de dificultad de los exámenes, ambos modelos presentan con frecuencia más errores en los cálculos matemáticos y en la interpretación del contexto que en el planteamiento.

Lee el siguiente apartado...